Hirn-Computer-Schnittstelle

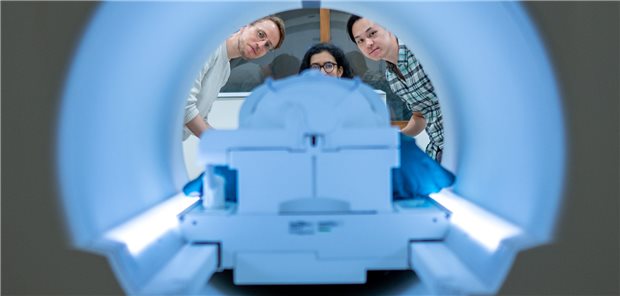

Hirnscanner liest Gedanken – aus fMRT-Bildern

Forscher in Texas versuchen, mit Aufnahmen aus einem fMRT Hirnströme und Durchblutungsänderungen sichtbar zu machen und dann mit KI zu interpretieren. Bis zum richtigen Gedankenlesen ist es allerdings noch weit.

Veröffentlicht:

Neue Perspektiven: Aus Bildern im MRT versuchen Forscher die Gedanken von Menschen zu entschlüsseln.

© Nolan Zunk / University of Texas in Austin / dpa

Austin. Mit Hirnscanner und KI haben US-Forscher bei willigen Probanden bestimmte Arten von Gedanken zumindest grob erfassen können.

So konnte ein von ihnen entwickelter Decoder mit Hilfe von sogenannten fMRT-Bildern in bestimmten experimentellen Situationen ungefähr wiedergeben, was den Teilnehmern durch den Kopf ging, wie das Team im Fachblatt „Nature Neuroscience“ schreibt. (Semantic reconstruction of continuous language from non-invasive brain recordings, Nature Neuroscience (2023). DOI: 10.1038/s41593-023-01304-9)

Hilfe für Patienten nach Schlaganfall?

Diese Hirn-Computer-Schnittstelle, bei der keine Operation notwendig ist, könnte irgendwann Menschen helfen, die ihr Sprachvermögen zum Beispiel in Folge eines Schlaganfalls verloren haben, so die Hoffnung der Forscher. Experten sind allerdings skeptisch.

Die Studienautoren der University of Texas betonen, dass mit ihrer Technologie nicht heimlich Gedanken ausgelesen werden könnten.

Geschichten im MRT angehört

Bei dem neuen Ansatz bildet ein Computer auf Grundlage von Hirnaktivitäten Wörter und Sätze. Diesen Sprachdecoder trainierten die Forschenden, indem sie drei Probanden 16 Stunden lang Geschichten hören ließen, während diese in einem funktionellen Magnetresonanztomografen (fMRT) lagen. Mit einem solchen fMRT können Durchblutungsänderungen von Hirnarealen sichtbar gemacht werden, die wiederum ein Indikator für die Aktivität der Neuronen sind.

Im nächsten Schritt bekamen die Probanden unter anderem neue Geschichten zu hören, während ihr Gehirn wieder in der fMRT-Röhre untersucht wurde. Der zuvor trainierte Sprachdecoder war nun in der Lage, aus den fMRT-Daten Wortfolgen zu erstellen, die den Forschenden zufolge den Inhalt des Gehörten weitgehend korrekt wiedergaben.

Hirnaktivitätsmuster mit Phrasen verknüpft

Das Team untersuchte auch die Leistung des Decoders, wenn die Probanden sich eigenständig eine Geschichte vorstellten oder einen kurzen animierten Stummfilm zu sehen bekamen.

Das Vorgehen der Forscher erklärt Rainer Goebel, Leiter der Abteilung für kognitive Neurowissenschaften an der niederländischen Maastricht-Universität, in einer unabhängigen Einordnung so: „Eine zentrale Idee der Arbeit war es, ein KI-Sprachmodell zu benutzen, um die Anzahl der möglichen Phrasen, die mit einem Hirnaktivitätsmuster im Einklang stehen, stark zu reduzieren.“

In einem Pressegespräch zur Studie veranschaulichte Mitautor Jerry Tang das Ergebnis der Tests: So habe der Decoder den Satz „Ich habe meinen Führerschein noch nicht“ als „Sie hat noch nicht einmal angefangen, Fahren zu lernen“ wiedergegeben. Das Beispiel illustriert laut Tang eine Schwierigkeit: „Das Modell ist sehr schlecht mit Pronomen – woran das liegt, wissen wir aber noch nicht.“

Noch zu viele Fehler

Insgesamt sei der Decoder dahingehend erfolgreich, dass viele ausgewählte Phrasen bei neuen, also nicht trainierten Geschichten Wörter des Originaltextes enthielten oder zumindest einen ähnlichen Bedeutungsgehalt aufwiesen, so Rainer Goebel. „Es gab aber auch recht viele Fehler, was für eine vollwertige Hirn-Computer-Schnittstelle sehr schlecht ist, da es für kritische Anwendungen – zum Beispiel Kommunikation bei Locked-In-Patienten – vor allem darauf ankommt, keine falschen Aussagen zu generieren.“

Noch mehr Fehler wurden generiert, als die Probanden sich eigenständig eine Geschichte vorstellen sollten oder einen kurzen animierten Stummfilm zu sehen bekamen, und der Decoder Ereignisse darin wiedergeben sollte. (dpa)